人工智能精度计算公式与显存的关系

1. 数据结构说明

在深度学习模型中,不同的数据类型(或数据结构)直接影响计算精度和内存需求。以下是常见的几种数据类型及其特点:

32位浮点数(FP32):

每个参数占用 4字节(32位 = 4字节)。

提供最高精度,适用于需要高精度的训练场景。

内存需求最大。

16位浮点数(FP16):

每个参数占用 2字节(16位 = 2字节)。

精度适中,内存需求减半,常用于推理或混合精度训练。

在保持一定精度的同时显著减少内存占用。

8位整数(INT8):

每个参数占用 1字节(8位 = 1字节)。

精度较低,但内存需求最小。

常用于量化后的模型推理,能有效降低资源占用。

补充说明:

还有更低位量化(如4位),每个参数占用 0.5字节,进一步减少内存需求,但精度损失可能更明显,适用于特定优化场景。

2. 数据结构差异

以下是32位、16位和8位数据结构的主要差异:

精度:

FP32 > FP16 > INT8。

FP32适合高精度计算,FP16提供平衡,INT8牺牲精度以换取效率。

内存占用:

FP32:4字节/参数。

FP16:2字节/参数。

INT8:1字节/参数。

更低位(如4位):0.5字节/参数。

应用场景:

FP32:训练大模型或需要高精度的任务。

FP16:推理或资源受限环境下的训练。

INT8:高效推理,尤其是量化后的模型。

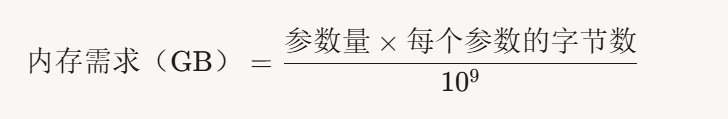

3. 内存计算方式

模型的内存需求主要取决于参数量和每个参数的字节数。计算公式如下:

参数量:以十亿(B)为单位,例如14B表示140亿个参数。

每个参数的字节数:根据数据类型确定:

FP32:4字节

FP16:2字节

INT8:1字节

4位量化:0.5字节

示例计算

以14B(140亿)参数模型为例:

FP32:14×4=56 GB

FP16:14×2=28 GB

INT8:14×1=14 GB

4位量化:14×0.5=7 GB

实际优化

在推理中,通过量化技术(如从FP32量化为INT8或4位),可以显著降低每个参数的字节数,从而减少内存需求。

除参数内存外,推理还需考虑激活函数、缓存等额外开销,但对于超大模型,参数内存通常占主导地位。

4. 总结

数据类型选择:

FP32(32位):4字节/参数,最高精度,最大内存需求。

FP16(16位):2字节/参数,适中精度,内存减半。

INT8(8位):1字节/参数,低精度,最小内存需求。

更低位量化(如4位):0.5字节/参数,进一步优化内存。

内存计算:

公式:内存(GB)= 参数量(B) × 每个参数的字节数。

示例:22B模型在INT8下需

22×1=22 GB,

4位量化下需

22×0.5=11 GB。

实际意义:

量化技术通过减小每个参数的字节数,使大模型能在内存受限的设备上运行。例如,14B模型量化到4位仅需7GB内存,适合家用显卡。

Comment